Come Usare Stable Diffusion: Guida e Panoramica Completa

Updated on

Benvenuti nella guida definitiva a Stable Diffusion. Se stai esplorando il mondo della generazione di immagini con l'IA, è molto probabile che tu abbia già sentito parlare di Stable Diffusion. È uno strumento che permette di creare arte digitale, foto realistiche e illustrazioni partendo da semplici descrizioni testuali (prompt) o da immagini di riferimento.

Questa pagina è pensata per offrire una panoramica completa, mostrandoti tutto ciò che è possibile realizzare. Per ogni argomento, troverai link ai nostri articoli di approfondimento, che ti permetteranno di esplorare più a fondo i concetti che più ti incuriosiscono.

1. Cos'è Stable Diffusion in Breve

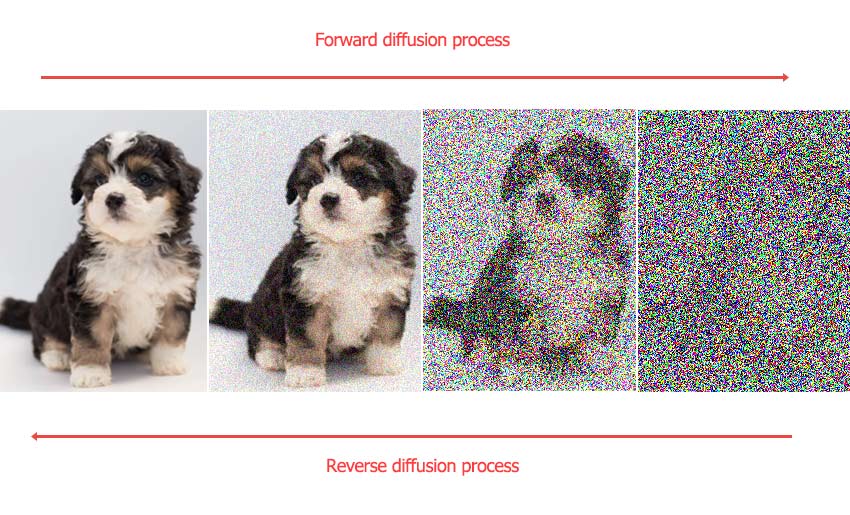

In termini tecnici, Stable Diffusion è un modello di deep learning open-source di tipo text-to-image. In pratica, è una potente intelligenza artificiale in grado di generare immagini uniche basandosi su dei prompt.

Perché Scegliere Stable Diffusion? A differenza di molti altri generatori di immagini AI, Stable Diffusion è open-source. Questa è la sua caratteristica distintiva principale. Ciò significa che chiunque può scaricare, utilizzare e modificare il software sul proprio computer. Questo offre un grado di libertà e controllo che la maggior parte dei modelli proprietari a codice chiuso non può garantire.

Stable Diffusion è Gratuito? Sì, il software in sé è gratuito da scaricare e utilizzare. L'unico costo è rappresentato dall'hardware necessario per farlo funzionare. Mentre alcuni servizi online richiedono un pagamento per l'accesso, eseguirlo localmente sul proprio PC è completamente gratuito.

2. Come Iniziare: La Tua Prima Creazione

Per iniziare a creare, hai due strade principali: utilizzare un comodo servizio online oppure installarlo in locale per avere la massima potenza.

Il Modo più Rapido: i Generatori Online

Il modo più veloce per generare la tua prima immagine è usare un servizio online. Queste piattaforme si occupano di tutta la parte tecnica, come l'installazione e i requisiti hardware, permettendoti di concentrarti subito sulla creazione dei prompt. Sono un ottimo modo per sperimentare con le basi del programma.

Per gli Utenti Esperti: Installazione in Locale

Per ottenere il massimo controllo e flessibilità, l'installazione in locale è l'approccio standard per gli utenti più esigenti. Questa scelta ti garantisce una generazione illimitata di immagini, una privacy completa (poiché nessun dato lascia il tuo computer) e l'accesso a un vasto ecosistema di modelli personalizzati ed estensioni non disponibili sulla maggior parte delle piattaforme online.

Verifica il tuo Hardware: Prima di iniziare, devi sapere se il tuo computer è all'altezza del compito. Abbiamo riassunto i requisiti di sistema generali come riferimento. Le prime versioni di Stable Diffusion erano ottimizzate principalmente per le schede Nvidia. Se il tuo computer monta una scheda AMD, puoi leggere la nostra guida su come installare Stable Diffusion con una GPU AMD.

Come ultima risorsa, puoi usare la CPU, anche se il programma potrebbe bloccarsi durante la generazione e l'upscaling delle immagini. Funziona per immagini da 512px, ma fa fatica con risoluzioni di 768px o superiori.

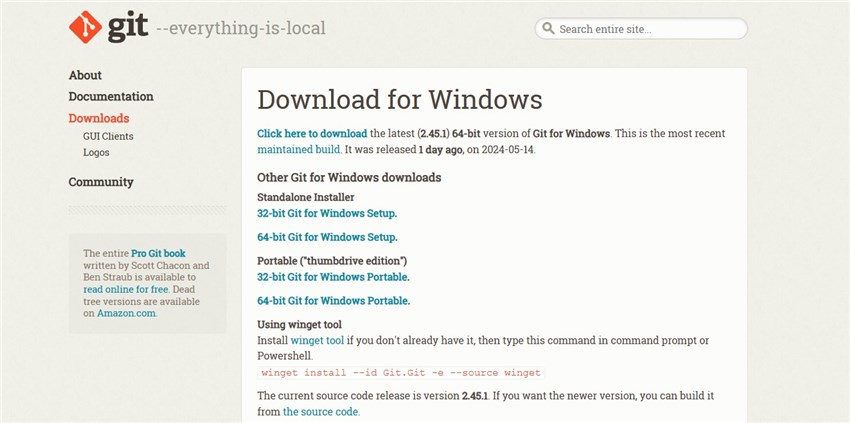

Installa il Software: Quando sei pronto per iniziare, il nostro tutorial passo-passo ti guiderà attraverso l'intero processo nella nostra guida su come configurare Stable Diffusion.

Scegli la tua Interfaccia (UI): Una buona interfaccia utente fa tutta la differenza. Abbiamo recensito le migliori interfacce per Stable Diffusion per aiutarti a scegliere quella giusta. AUTOMATIC1111 è una delle preferite dalla community, specialmente per i principianti.

3. I Concetti Chiave: Padroneggiare le Basi

Una volta completata la configurazione, interagirai con Stable Diffusion utilizzando alcune tecniche fondamentali.

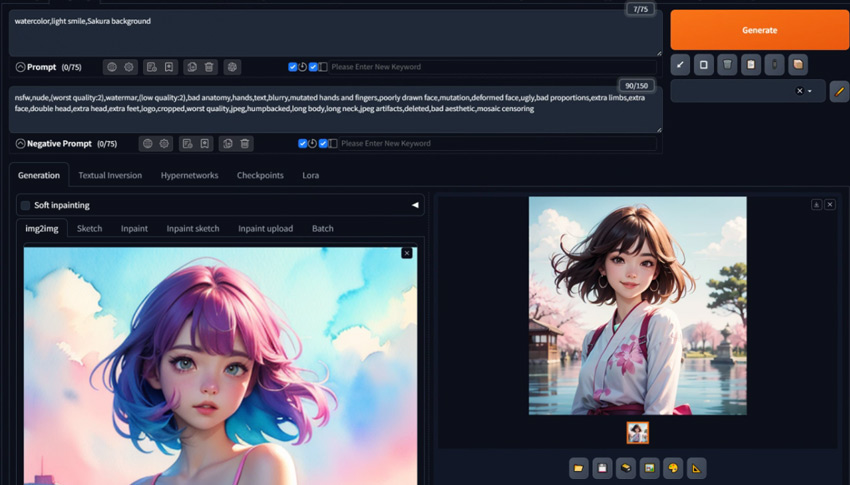

Text-to-Image (txt2img): È il processo di base. Fornisci un prompt testuale e l'IA genera un'immagine da zero basandosi su quella descrizione.

Image-to-Image (img2img): Questo flusso di lavoro utilizza un'immagine esistente come punto di partenza. Fornisci un'immagine iniziale insieme a un prompt testuale e l'IA trasforma l'immagine secondo le tue istruzioni.

Inpainting: Hai bisogno di correggere una mano venuta male o di aggiungere un oggetto a un'immagine esistente? L'inpainting ti permette di "mascherare" un'area specifica e rigenerare solo quella parte.

Outpainting: Se l'immagine generata ti sembra troppo "stretta" o ritagliata, l'outpainting ti consente di espandere la tela, e l'IA riempirà intelligentemente il nuovo spazio. Scopri come funziona qui.

4. Il Prompting: Come Comunicare con l'IA

La qualità dell'immagine finale è direttamente legata alla qualità del tuo prompt, così come alle impostazioni dei parametri, alla scelta del modello e molto altro. Un prompt ben strutturato è un ottimo punto di partenza.

Per strutturare i tuoi prompt in un modo che Stable Diffusion possa comprendere, prova a includere i seguenti componenti, per poi affinarli in base all'immagine ottenuta.

- Soggetto: Qual è il fulcro principale? Ad esempio: "1girl" (una ragazza), un leone, una figura 3D di una "blink box", ecc.

- Medium: Si tratta di una fotografia, un dipinto, uno schizzo o un altro medium/tecnica?

- Stile: Qual è lo stile artistico? Art déco, futurismo, pixel art, minimalismo, ecc.

- Dettagli: Modificatori per la composizione, l'illuminazione, il colore e la qualità dell'immagine.

E non dimenticare i Prompt Negativi, che dicono all'IA cosa evitare. Basandoci sulle discussioni degli utenti su Reddit e sui forum dedicati a Stable Diffusion, abbiamo testato e trovato alcuni prompt negativi che funzionano bene con diversi modelli. Puoi visitare questa guida per copiare i prompt negativi più efficaci.

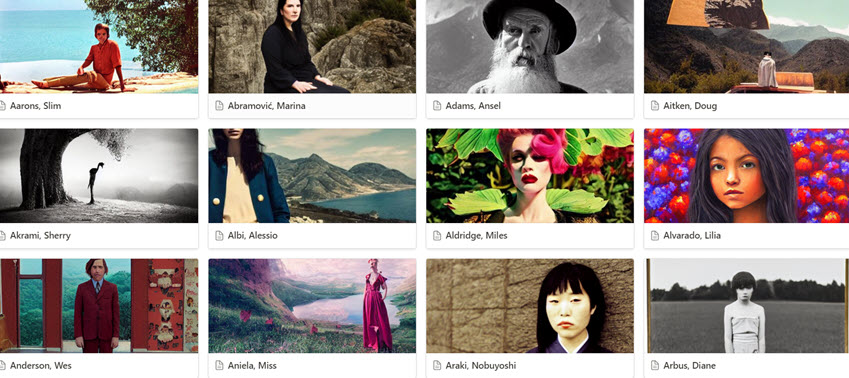

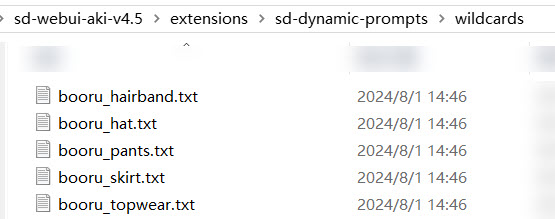

Se vuoi generare immagini con Stable Diffusion in batch, ma trovi noioso variare manualmente parte dei prompt, il modo più semplice è usare i Prompt Dinamici per testare diverse variazioni. Per farti un'idea, le "wildcard" usate nei prompt dinamici sono file che coprono ciascuno una categoria, come ad esempio wildcard per le acconciature, per l'abbigliamento (come mostrato sopra), per le pose dei personaggi, ecc. La funzione dei prompt dinamici inserirà e varierà in modo casuale questi elementi nei tuoi prompt.

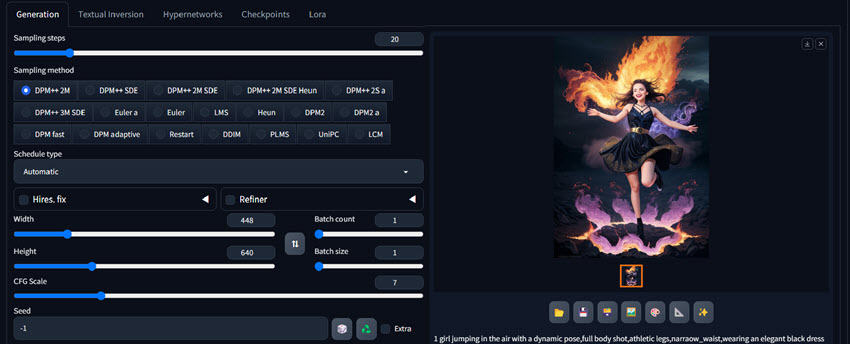

5. Decodificare le Impostazioni: Guida ai Parametri Chiave

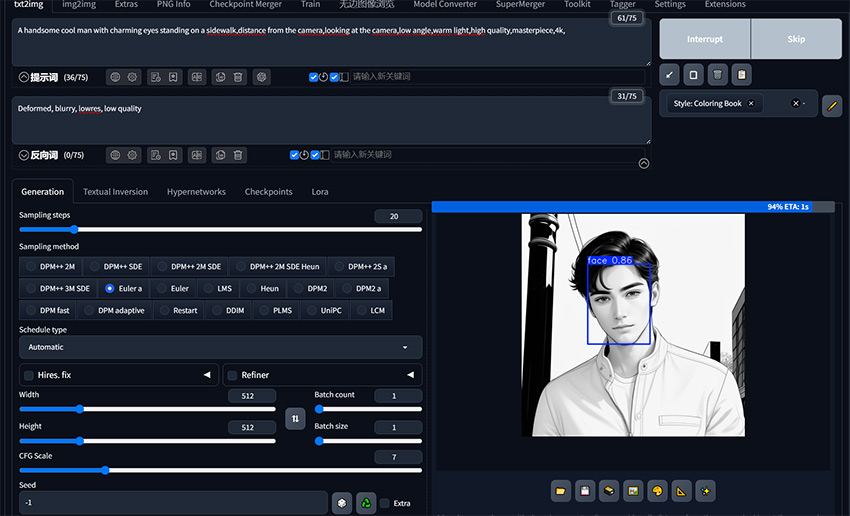

Oltre al prompt, ci sono alcuni selettori (slider) e impostazioni chiave che influenzeranno drasticamente i tuoi risultati. Di seguito trovi alcuni dei parametri che incontrerai in Stable Diffusion.

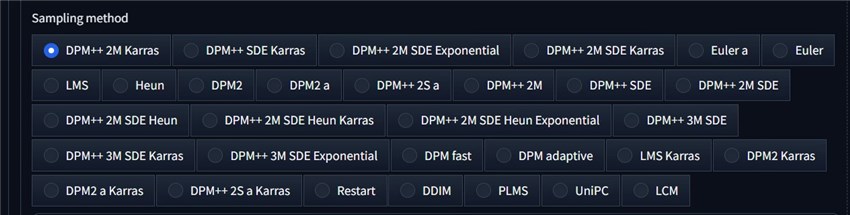

Metodo di Campionamento (Sampling Method): Determina il processo che l'IA utilizza per trasformare il "rumore" iniziale in un'immagine finita. Sampler diversi offrono risultati estetici e velocità differenti.

Passaggi di Campionamento (Sampling Steps): È il numero di iterazioni che il sampler esegue. Più passaggi possono significare maggiori dettagli, ma richiederanno più tempo.

Scala CFG (Guidance Scale): Controlla quanto strettamente l'IA debba attenersi al tuo prompt. Un valore basso dà all'IA più libertà creativa, mentre un valore alto la costringe a seguire le tue istruzioni alla lettera. Per trovare il valore ottimale, dai un'occhiata ai nostri test sulla Scala CFG.

Seed: Il seed in Stable Diffusion è un numero che inizializza il processo di generazione casuale. L'IA parte da un campo di rumore casuale e lo raffina per creare un'immagine; il seed determina proprio quel pattern di rumore iniziale. Usando lo stesso prompt, le stesse impostazioni e lo stesso seed si otterrà sempre la stessa identica immagine.

Intensità di Denoising (Denoising Strength): Utilizzato in Img2Img, questo cursore controlla quanto l'IA modificherà l'immagine originale. Un valore basso apporta piccole modifiche, mentre un valore alto può creare qualcosa di completamente nuovo. Spieghiamo tutto nella nostra guida sulla Denoising Strength.

6. Personalizzare la Tua Esperienza con Stable Diffusion

È qui che Stable Diffusion brilla veramente. Puoi cambiare radicalmente i suoi risultati sostituendo i componenti principali e aggiungendo modifiche leggere.

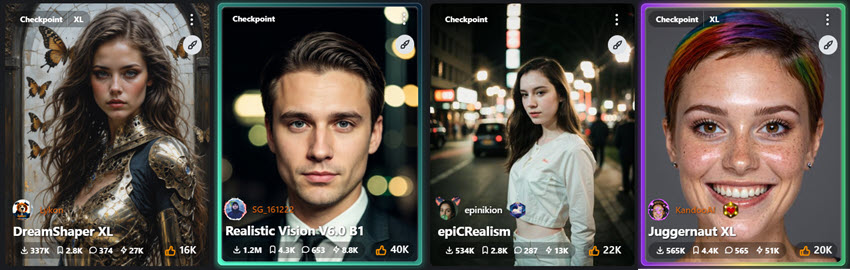

Modelli Checkpoint: Sono file di grandi dimensioni che contengono la "conoscenza" di base dell'IA. Scaricando e utilizzando diversi modelli addestrati dalla community, puoi passare istantaneamente dalla generazione di ritratti fotorealistici alla creazione di arte in stile anime. Per iniziare rapidamente, puoi usare uno di questi migliori modelli per Stable Diffusion.

Per i fan degli anime, abbiamo una lista curata dei migliori modelli anime e un approfondimento su Waifu Diffusion.

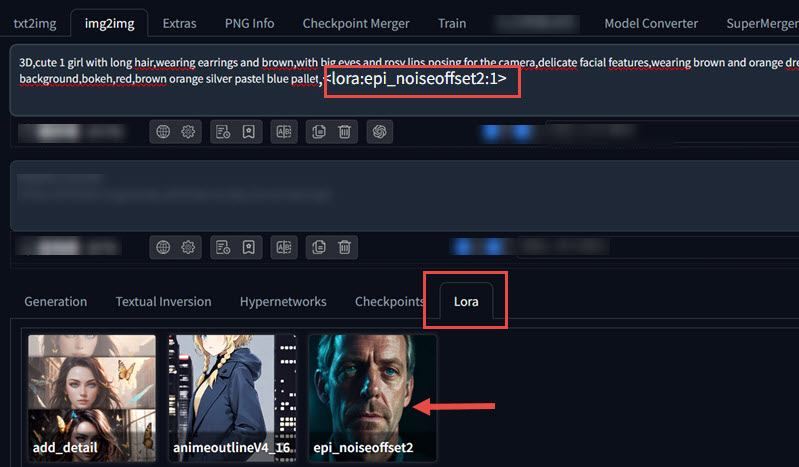

LoRA (Low-Rank Adaptation): Si tratta di piccoli file che applicano stili, personaggi o concetti specifici al tuo modello checkpoint principale. Sono un modo leggero e potente per personalizzare le tue creazioni. Scopri tutto sui LoRA qui.

VAE (Variational Autoencoder): Un VAE è un piccolo file che accompagna il tuo modello e aiuta a decodificare l'immagine finale. Un buon VAE può correggere i colori sbiaditi e aggiungere dettagli più fini.

Textual Inversion: Simili ai LoRA, sono file minuscoli che insegnano all'IA una nuova "parola" o un nuovo concetto, perfetti per incorporare un oggetto o uno stile specifico nelle tue immagini.

Addestrare i Tuoi Modelli: Per il massimo della personalizzazione, puoi addestrare i tuoi modelli. Che tu voglia addestrare un modello Stable Diffusion completo o cimentarti nel processo più accessibile dell'addestramento di un LoRA, il potere è nelle tue mani.

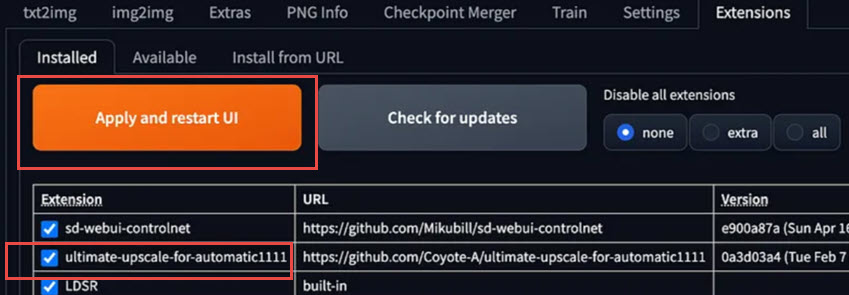

7. Workflow Avanzati ed Estensioni

Oltre ai flussi di lavoro di base, le funzionalità di Stable Diffusion possono essere ampliate con strumenti ed estensioni specializzate, che offrono un controllo molto più granulare sul risultato finale.

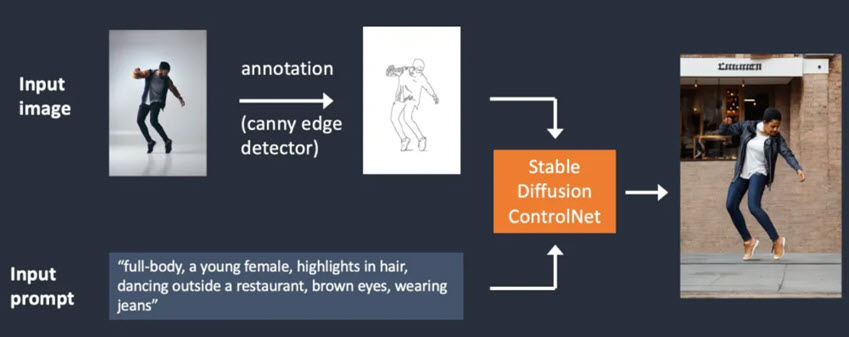

ControlNet è un'estensione che ti permette di guidare la composizione di un'immagine generata utilizzando un'immagine di partenza. Ad esempio, puoi fornire una mappa di profondità (depth map), una mappa dei contorni (canny edge map) o lo scheletro della posa di una persona. L'IA genererà quindi un'immagine che rispetta la struttura del tuo input. È uno strumento standard per gli utenti che richiedono un controllo preciso sulla posa del soggetto e sulla disposizione della scena.

Rifinire e Fare l'Upscaling: Le tue prime creazioni sono spesso di piccole dimensioni. Per creare opere d'arte di grandi dimensioni e stampabili, dovrai fare l'upscaling (cioè aumentare la risoluzione). La funzione integrata Hires. Fix è un ottimo punto di partenza e, per risultati ancora migliori, puoi usare strumenti avanzati come l'upscaler LDSR.

Correggere Volti e Dettagli: A volte l'IA può avere difficoltà con volti e mani. Fortunatamente, strumenti come ADetailer possono rilevare e correggere automaticamente volti e mani nelle tue immagini.

Estensioni Essenziali: La community di Stable Diffusion ha creato un numero incredibile di estensioni per aggiungere nuove funzionalità. La nostra panoramica sulle estensioni per Stable Diffusion è un ottimo punto di partenza. Alcuni esempi popolari includono strumenti per controlli avanzati come i seguenti.

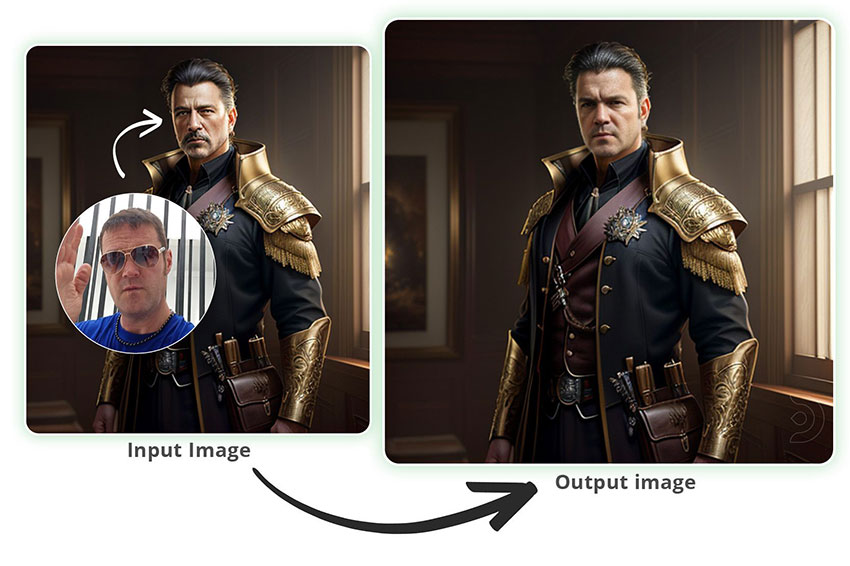

- Face Swapping con Reactor: Utilizzare un'estensione come Reactor per sostituire un volto in un'immagine generata con una foto di partenza.

- Tiling: Creare pattern ripetibili e senza interruzioni (seamless) per texture o sfondi.

- Estensione per la Rimozione dello Sfondo: Isolare il soggetto rimuovendo automaticamente lo sfondo con Stable Diffusion da un'immagine esistente o da nuove creazioni.

Combinare i Flussi di Lavoro

Puoi combinare questi strumenti per ottenere risultati sorprendenti. Ad esempio, un flusso di lavoro Sketch-to-Image potrebbe usare un modello ControlNet Canny per trasformare un disegno al tratto in un'immagine a colori, mentre lo Style Transfer può essere realizzato utilizzando un'immagine in img2img con una bassa intensità di denoising.

Puoi anche sperimentare con Img2Img e Inpainting per modifiche complesse, come alterare parti specifiche di un'immagine, esplorare come creare persone fotorealistiche o imparare a cambiare e rimuovere i vestiti.

8. Risoluzione dei Problemi Comuni

Quando si utilizza un'installazione locale di Stable Diffusion, è possibile incontrare diversi errori tecnici comuni. Abbiamo raccolto soluzioni che funzionano per la maggior parte degli utenti e testato i passaggi quando siamo stati in grado di replicare l'errore. Di seguito sono riportati i problemi più comuni e le relative soluzioni verificate.

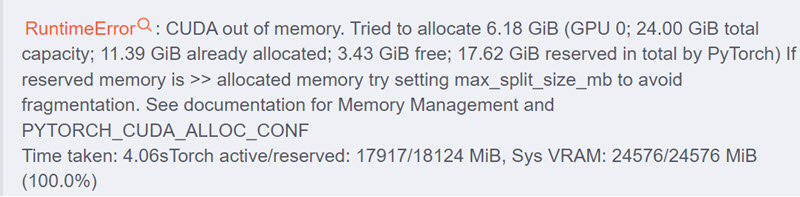

Out of Memory: È l'errore più frequente, tipicamente causato da una VRAM insufficiente per le dimensioni dell'immagine o il numero di batch richiesti. Scopri come risolvere gli errori CUDA out of memory e rendere il tuo workflow più efficiente.

Problemi di Prestazioni: Se il programma è lento, potrebbe essere perché non sta utilizzando correttamente la tua GPU. Puoi anche imparare alcuni consigli generali su come rendere Stable Diffusion più veloce.

Errori di Caricamento: Se un nuovo modello o un'estensione non si carica, spesso è dovuto a un posizionamento errato dei file o a dipendenze mancanti. Ecco alcuni modi per risolvere il problema "model failed to load".

Rimanere Aggiornati: Nuove funzionalità e miglioramenti delle prestazioni vengono rilasciati regolarmente. Impara come aggiornare Stable Diffusion per assicurarti di avere sempre gli strumenti più recenti e performanti.

Se stai esplorando l'intero panorama o preferisci non perdere tempo a risolvere errori, non perderti la nostra recensione delle migliori alternative a Stable Diffusion.

Conclusioni

Ora hai una mappa completa del mondo di Stable Diffusion. Hai visto come iniziare, come creare il prompt perfetto, come personalizzare l'IA secondo le tue esatte esigenze e come utilizzare strumenti di livello professionale per ottenere risultati straordinari.

La pratica è la chiave per padroneggiare queste tecniche. Non aver paura di provare prompt strani, spingere gli slider al limite e combinare tecniche diverse. Salva questa guida tra i preferiti come punto di riferimento e clicca sugli articoli di approfondimento ogni volta che sei pronto a imparare qualcosa di nuovo. Ora, vai e crea qualcosa di straordinario!

- Upscale, riduci rumore e migliora i dettagli con l'AI.

- Elabora in batch immagini fino a risoluzioni 4K/8K/16K e oltre.

- Evita l'effetto "pittorico" per risultati più naturali.

- Ideale per arte AI, foto e immagini vecchie o rovinate.