I 4 migliori upscaler video gratuiti e open source

Non tutti dispongono del budget necessario per acquistare software professionali di miglioramento video basati su IA. Se avete mai navigato su Reddit, GitHub o forum di video editing, vi sarete probabilmente imbattuti in utenti che pongono sempre la stessa domanda: "Esistono buoni strumenti AI open-source in grado di aumentare la risoluzione o migliorare la qualità dei video?"

Sebbene le opzioni commerciali siano spesso più rifinite e potenti, una manciata di progetti open-source ha guadagnato popolarità offrendo funzionalità basate sull'intelligenza artificiale come upscaling, deblurring (rimozione della sfocatura) e denoising (riduzione del rumore), il tutto senza alcun costo. Alcuni sono progettati specificamente per i contenuti anime, mentre altri puntano a un miglioramento video più generico. Ma quanto sono efficaci nella pratica? E quali compromessi comporta il loro utilizzo?

Questo articolo vi guiderà alla scoperta di alcuni dei più popolari upscaler e enhancer video AI open-source oggi disponibili, analizzando i loro punti di forza, i loro limiti e cosa aspettarsi durante l'installazione e l'uso.

I più popolari Upscaler/Enhancer Video AI Open-Source

Non mancano certo gli strumenti open-source che promettono di aumentare la risoluzione o migliorare i video tramite l'IA. Alcuni sono creati da ricercatori e mantenuti da collaboratori su GitHub, mentre altri vengono perfezionati da sviluppatori indipendenti per un uso pratico e quotidiano.

Di seguito, presentiamo alcuni degli upscaler e enhancer video open-source più noti a cui gli utenti si rivolgono spesso. Ciascuno di essi ha i propri punti di forza, limitazioni e peculiarità di cui è bene essere a conoscenza prima di iniziare.

Video2X

Piattaforme supportate: Windows (pieno supporto), Linux (supporto limitato)

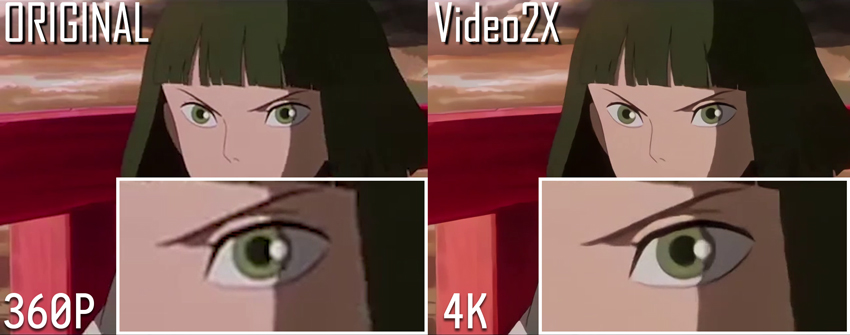

Video2X è un popolare strumento open-source che esegue l'upscaling dei video estraendo i singoli fotogrammi, ingrandendoli con upscaler di immagini basati su IA e ricostruendo poi un video ad alta risoluzione con i fotogrammi elaborati.

Supporta una varietà di motori di upscaling AI come waifu2x, waifu2x-ncnn-vulkan, SRMD, Anime4KCPP e altri, rendendolo abbastanza versatile sia per gli anime che per i filmati reali. Permette inoltre di personalizzare la risoluzione di output, il framerate e il formato di codifica. Per gli utenti Windows è disponibile una semplice interfaccia grafica, mentre gli utenti Linux dovranno affidarsi alle operazioni da riga di comando.

- Supporta molteplici backend AI per adattarsi a diversi tipi di contenuti

- Offre una GUI per Windows che semplifica l'uso per gli utenti meno tecnici

- Supporta l'elaborazione batch per video lunghi o intere cartelle

- Gratuito e open-source, senza restrizioni di funzionalità o filigrane

- L'elaborazione è lenta senza accelerazione GPU; una GPU NVIDIA è fortemente raccomandata

- L'audio non viene processato insieme al video e deve essere ricollegato separatamente

- L'installazione e la configurazione dei modelli possono creare confusione per i principianti

- Il supporto per Linux è limitato e richiede una configurazione manuale

- Questo strumento non è eseguito in modo nativo su macOS

Installazione e utilizzo:

1. Compilare il progetto Video2X sul proprio computer

- Guida alla compilazione di Video2X su Windows: https://docs.video2x.org/building/windows.html

- Guida alla compilazione della GUI Qt6 di Video2X su Windows: https://docs.video2x.org/building/windows-qt6.html

- Guida alla compilazione di Video2X su Linux: https://docs.video2x.org/building/linux.html

2. Scaricare e installare Video2X

Per eseguire Video2X senza problemi, il sistema deve soddisfare i seguenti requisiti hardware minimi.

CPU

- I binari precompilati richiedono CPU con supporto AVX2.

- Intel: Haswell (Q2 2013) o più recenti

- AMD: Excavator (Q2 2015) o più recenti

GPU

- La GPU deve supportare Vulkan.

- NVIDIA: Kepler (serie GTX 600, Q2 2012) o più recenti

- AMD: GCN 1.0 (serie Radeon HD 7000, Q1 2012) o più recenti

- Intel: HD Graphics 4000 (Q2 2012) o più recenti

Suggerimento: Se il vostro computer non dispone di una GPU potente, potete comunque utilizzare Video2X gratuitamente su Google Colab. Google fornisce l'accesso a GPU ad alte prestazioni come NVIDIA T4, L4 o A100, che potete usare fino a 12 ore per sessione.

Per installare su Windows (versione da riga di comando)

Potete scaricare l'ultima release precompilata da GitHub. Ecco come installarla nella directory utente locale:

Una volta estratto, aggiungete %LOCALAPPDATA%\Programs\video2x alle variabili d'ambiente del sistema per un accesso più semplice.

Per installare la GUI Windows Qt6

Se preferite un'interfaccia grafica, la versione Qt6 di Video2X offre un'esperienza più pulita. Scaricate il file di installazione — video2x-qt6-windows-amd64-installer.exe — dalla pagina delle release, quindi fate doppio clic per avviarlo.

La procedura guidata vi accompagnerà durante il processo di installazione. Potete selezionare il percorso di installazione e decidere se creare un collegamento sul desktop.

Per installare su Linux

Gli utenti Linux dovrebbero seguire le istruzioni nella guida ufficiale all'installazione per Linux.

3. Eseguire Video2X

Potete eseguire Video2X sia tramite riga di comando sia attraverso la sua GUI (su Windows).

Per utilizzare la riga di comando, fate riferimento alla documentazione della CLI. Sarete in grado di definire i percorsi di input e output, il modello AI come realesrgan, le opzioni di output e molto altro.

Comando di esempio:

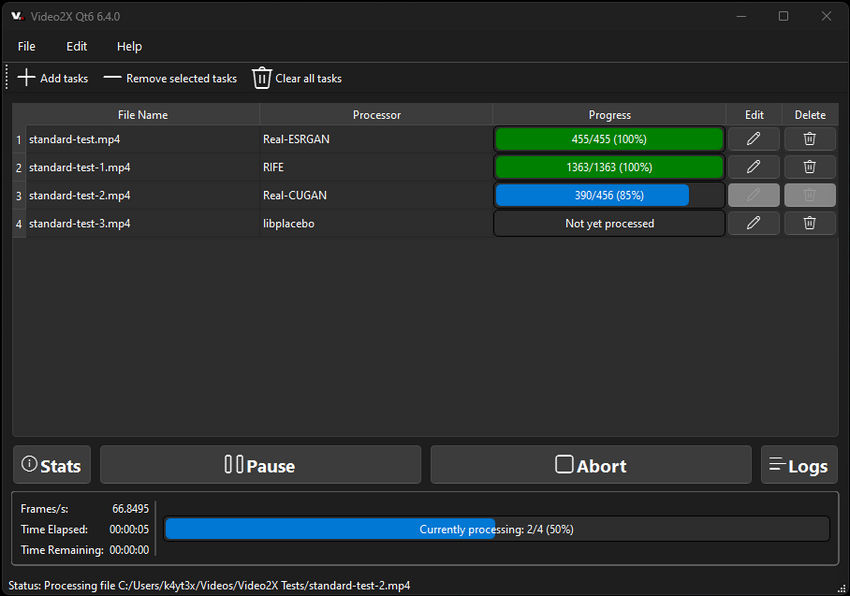

Per utilizzare la GUI, basta avviare Video2X Qt6. Caricate il vostro video, configurate le impostazioni come il backend GPU, la modalità di elaborazione e i filtri, quindi fate clic sul pulsante "Run" per avviare l'upscaling.

Potrebbe interessarti anche: Recensione approfondita di Video2X >>

Real-ESRGAN

Piattaforme supportate: Windows, Linux, macOS

Real-ESRGAN è un upscaler AI open-source molto diffuso, sviluppato dallo stesso team di ESRGAN. Basato sul framework PyTorch, offre un upscaling di immagini e video di alta qualità utilizzando reti generative avversarie (GAN) pre-addestrate. Sebbene sia stato originariamente progettato per la super-risoluzione di singole immagini, Real-ESRGAN può essere applicato anche ai video elaborandoli fotogramma per fotogramma, rendendolo una scelta eccellente per ripristinare contenuti video a bassa risoluzione o compressi.

Offre prestazioni particolarmente buone su scene del mondo reale — come paesaggi, volti o filmati di bassa qualità girati con lo smartphone — ed è noto per la sua capacità di ripristinare i dettagli più fini, riducendo al contempo rumore e artefatti di compressione.

- Qualità di miglioramento dell'immagine allo stato dell'arte, specialmente per foto e video reali

- Disponibili molteplici modelli pre-addestrati (generale, anime, restauro volti, ecc.)

- Mantenuto attivamente e supportato da un solido team di ricerca

- Può essere integrato in script o flussi di lavoro video personalizzati

- Nessuna GUI integrata; richiede l'uso della riga di comando o script manuali

- Richiede l'estrazione e la ricomposizione dei fotogrammi per l'uso su video (processo non automatizzato)

- Richiede un ambiente Python e una conoscenza di base di PyTorch

- L'elaborazione può essere lenta su CPU; una GPU è fortemente consigliata per un uso pratico

Installazione e utilizzo:

1. Installare Python e le dipendenze

- Assicurarsi che Python 3.7 o successivo sia installato

- Clonare la repository:

- Installare i pacchetti richiesti

cd Real-ESRGAN

We use BasicSR for both training and inference

pip install basicsr

facexlib and gfpgan are for face enhancement

pip install facexlib

pip install gfpgan

pip install -r requirements.txt

python setup.py develop

2. Scaricare i modelli pre-addestrati

code CodeIl progetto supporta vari modelli:

- RealESRGAN_x4plus (uso generale)

- RealESRGAN_x4plus_anime_6B (immagini anime)

- realesr-general-x4v3 (per immagini compresse)

Scaricate i file del modello .pth desiderati dalla release di GitHub o dai link forniti.

3. Preparare il video (estrazione dei fotogrammi)

Usate FFmpeg per estrarre i fotogrammi dal vostro video di input:

4. Eseguire Real-ESRGAN sui fotogrammi estratti

Comando di esempio (per upscaling 4x):

5. Ricombinare i fotogrammi in un video

Usate di nuovo FFmpeg:

6. (Opzionale) Aggiungere nuovamente l'audio dal video originale

Real-ESRGAN è più adatto per gli utenti che hanno familiarità con Python e gli strumenti da riga di comando, o per coloro che desiderano integrare un upscaling di alta qualità in pipeline automatizzate. Sebbene la configurazione sia più tecnica rispetto alle opzioni con GUI, i risultati visivi spesso parlano da soli, specialmente nel ripristino dei dettagli in filmati sfocati o a bassa risoluzione.

Suggerimento: Proprio come Video2X, anche Real-ESRGAN può essere eseguito su Google Colab. Date un'occhiata a questo video per scoprire come usare Colab per aumentare la risoluzione video fino a HD o addirittura 4K senza bisogno di una potente GPU locale.

Waifu2x Extension GUI

Piattaforma supportata: Windows

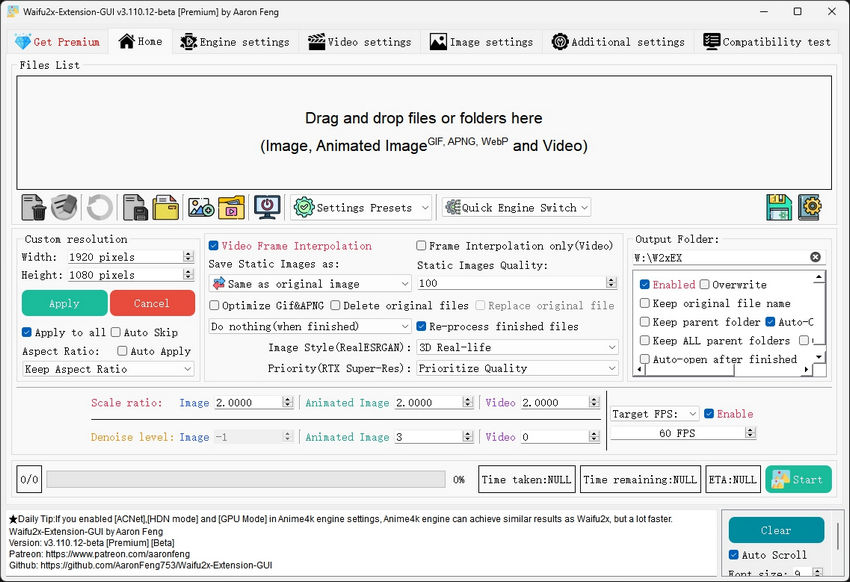

Waifu2x Extension GUI è un'applicazione desktop user-friendly, esclusiva per Windows, che integra diversi upscaler AI — tra cui waifu2x, Real-ESRGAN e Anime4K — in un'unica interfaccia grafica. Originariamente progettata per immagini e video in stile anime, si è poi espansa per supportare anche contenuti reali con opzioni di modelli aggiuntivi. È ampiamente apprezzata per la sua facilità di installazione e utilizzo, senza richiedere operazioni da riga di comando.

A differenza di molti strumenti open-source, Waifu2x Extension GUI è costruita per la praticità: gestisce l'estrazione dei fotogrammi, l'upscaling, la ricostruzione del video e persino la sincronizzazione dell'audio, tutto all'interno della stessa interfaccia. Questo la rende una delle opzioni più adatte ai principianti disponibili per il miglioramento video basato su IA su Windows.

- GUI all-in-one che supporta l'upscaling di immagini, GIF e video

- Include molteplici backend AI (waifu2x-ncnn-vulkan, Real-ESRGAN, Anime4K, SRMD)

- Supporto integrato per il muxing video/audio — non è necessario usare FFmpeg da riga di comando

- Offre elaborazione batch e impostazioni avanzate per utenti esperti

- Non richiede Python o dipendenze esterne

- Solo per Windows — nessun supporto per macOS o Linux

- L'elaborazione può richiedere molto tempo su GPU di fascia bassa

- Le opzioni dei modelli e la frequenza degli aggiornamenti dipendono dalla manutenzione dello sviluppatore

- Installer leggermente pesante (~1.5 GB a causa dei modelli e delle dipendenze inclusi)

Installazione e utilizzo:

1. Scaricare l'installer

Andate alla pagina delle release del progetto su GitHub o Gitee: https://github.com/AaronFeng753/Waifu2x-Extension-GUI. Scegliete l'ultima versione .exe (es. Waifu2x-Extension-GUI-v...-Installer.exe).

2. Installare e avviare il programma

Eseguite l'installer. Una volta completato, aprite l'applicazione dal collegamento sul desktop o dal menu Start.

3. Caricare il video

Trascinate e rilasciate il vostro file video nel programma, oppure fate clic su "Add Files" e selezionate il vostro input.

4. Scegliere le impostazioni di upscaling

- Selezionare il modello AI (es. Real-ESRGAN, waifu2x-ncnn-vulkan o Anime4KCPP)

- Impostare il moltiplicatore della risoluzione di output (es. 2× o 4×)

- Opzionale: applicare denoising, interpolazione dei fotogrammi o riduzione degli artefatti

5. Avviare l'elaborazione

Fate clic sul pulsante "Start". L'applicazione gestirà tutto automaticamente: estrarrà i fotogrammi, eseguirà l'upscaling, ricostruirà il video e sincronizzerà l'audio.

6. Accedere all'output

Il video con risoluzione aumentata verrà salvato nella cartella di output specificata, pronto per essere utilizzato o caricato.

Waifu2x Extension GUI è ideale per gli utenti che desiderano solidi risultati di upscaling AI senza dover toccare codice o configurare ambienti complessi. Sebbene sia meno personalizzabile degli strumenti basati su script, offre un'esperienza "pronta all'uso" di alto livello, difficile da battere, specialmente per anime e video web a bassa risoluzione.

Anime4K

Piattaforme supportate: Windows, macOS, Linux (tramite lettori video o script personalizzati)

Anime4K è un algoritmo di upscaling video leggero e open-source, progettato specificamente per contenuti anime e con disegni al tratto (line-art). A differenza di altri strumenti che si basano su deep learning o modelli GAN, Anime4K utilizza shader OpenCL o Vulkan efficienti che vengono eseguiti direttamente sulla GPU. Questo lo rende veloce, in tempo reale e adatto anche a hardware di fascia bassa.

Invece di estrarre e riassemblare i fotogrammi video, Anime4K viene tipicamente utilizzato all'interno di lettori video come MPV o VLC tramite script per shader. Può anche essere applicato offline utilizzando filtri FFmpeg o strumenti da riga di comando, ma il suo più grande punto di forza risiede nel miglioramento della riproduzione in tempo reale, rendendo istantaneamente più puliti e nitidi vecchi anime o video web a bassa risoluzione.

- Miglioramento in tempo reale con quasi nessun ritardo

- Estremamente leggero — funziona anche su GPU integrate

- Ottimo per anime, cartoni animati e contenuti in stile line-art

- Funziona all'interno di MPV, VLC o con script personalizzati — non è necessaria l'estrazione separata dei fotogrammi

- Supporto multipiattaforma

- Non adatto per contenuti video fotografici o reali

- Nessuna interfaccia grafica o installer preconfigurato

- Richiede una configurazione manuale per l'integrazione con i lettori video

- La qualità di output non è nitida o dettagliata come quella degli upscaler basati su deep learning

Installazione e utilizzo:

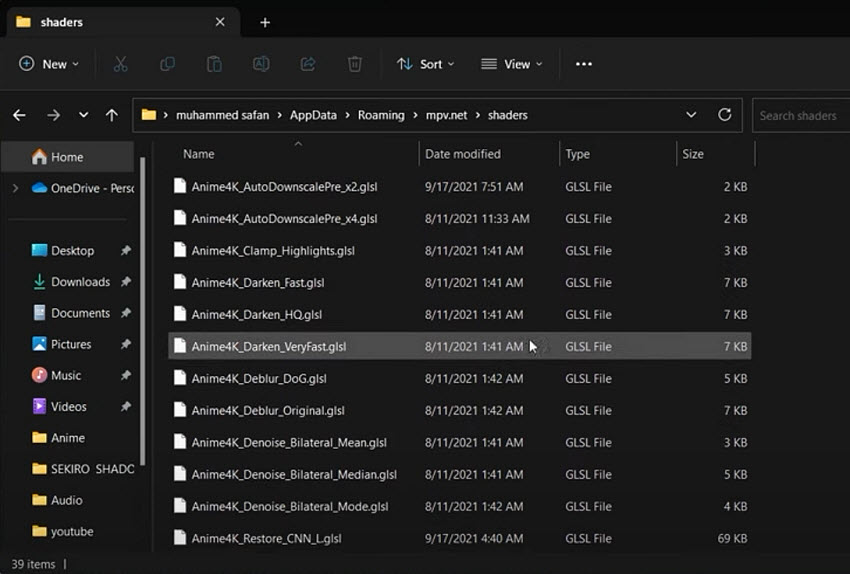

Opzione 1: Riproduzione in tempo reale con MPV

- Scaricare il lettore MPV da: https://mpv.io/

- Clonare o scaricare la repository di Anime4K: https://github.com/bloc97/Anime4K

- Posizionare i file dello shader (es. Anime4K_Clamp_Hybrid.glsl) nella cartella "shaders" di MPV.

- Modificare il file mpv.conf per attivare lo shader: glsl-shaders="~~/shaders/Anime4K_Clamp_Hybrid.glsl"

- Aprite il vostro video con MPV e il miglioramento verrà applicato in tempo reale.

Leggi anche: Come usare Anime4K con MPV: pro, contro e caratteristiche >>

Opzione 2: Elaborazione offline con FFmpeg (Utenti avanzati)

Alcuni fork (come Anime4KCPP) forniscono modi per eseguire i filtri di Anime4K direttamente sui file video, ma ciò richiede la compilazione dello strumento o l'utilizzo di build specifiche di FFmpeg con supporto per gli shader — una procedura non adatta ai principianti.

Anime4K è la scelta ideale per gli appassionati di anime o per chiunque desideri un miglioramento visivo istantaneo per contenuti animati a bassa risoluzione. Non offre le capacità di restauro profondo di modelli AI come Real-ESRGAN o Video2X, ma la sua velocità e semplicità lo rendono un'opzione eccellente per la riproduzione o per un miglioramento leggero.

Come potete vedere, gli enhancer video open-source si presentano in molte forme: dalle GUI user-friendly come Waifu2x Extension GUI alle soluzioni leggere basate su shader come Anime4K.

Sebbene questi strumenti siano potenti e gratuiti, comportano anche alcuni compromessi che potrebbero risultare frustranti per i principianti o persino per gli utenti più esperti.

Nella prossima sezione, analizzeremo alcune delle sfide più comuni che le persone affrontano quando lavorano con queste soluzioni open-source.

Difficoltà Comuni nell'Utilizzo degli Enhancer Video AI Open-Source

Sebbene gli upscaler video AI open-source offrano capacità impressionanti, spesso presentano una curva di apprendimento ripida. Molti utenti scaricano questi strumenti aspettandosi un'esperienza "plug-and-play", solo per scoprire che farli funzionare richiede passaggi tecnici, gestione delle dipendenze o ore di tentativi ed errori. Ecco alcune delle sfide più comuni che si incontrano.

1. Installazione e Configurazione Complesse

Molti enhancer video AI open-source si basano su Python, PyTorch o altri framework che richiedono un'installazione manuale. Potrebbe essere necessario clonare repository da GitHub, installare dipendenze, configurare variabili d'ambiente o scaricare modelli AI separati, tutto questo prima ancora di poter elaborare un singolo video. Se non si ha già familiarità con questi strumenti, il processo può sembrare opprimente.

2. Mancanza di un'Interfaccia Unificata

A differenza degli strumenti commerciali, che di solito offrono interfacce rifinite e flussi di lavoro ottimizzati, la maggior parte dei progetti open-source si concentra sulla funzionalità AI di backend. Spesso è necessario estrarre i fotogrammi video con FFmpeg, eseguire l'upscaling separatamente e poi riassemblare manualmente il video. Esistono opzioni con GUI, ma sono spesso limitate a Windows o possono essere obsolete.

3. La Gestione dell'Audio è Spesso Trascurata

Molti strumenti si concentrano esclusivamente sulla parte visiva del video, lasciando l'audio fuori dall'equazione. Di conseguenza, gli utenti devono estrarre e ricollegare manualmente le tracce audio utilizzando FFmpeg o altri strumenti. Questo aggiunge un ulteriore passaggio a un flusso di lavoro già complesso e aumenta la possibilità di errori, come la desincronizzazione.

4. Supporto e Documentazione Limitati

Poiché questi strumenti sono spesso progetti amatoriali o demo di ricerca, di solito mancano di canali di supporto formali. La documentazione può essere incoerente, obsoleta o troppo tecnica per i principianti. Se ci si blocca, l'unica risorsa potrebbe essere cercare tra le issue di GitHub, i thread di Reddit o i forum online, il che non sempre porta a risposte chiare.

Un'Alternativa più Semplice ed Efficiente agli Upscaler/Enhancer Video Open-Source

Se avete mai faticato a far funzionare un upscaler AI open-source, non siete soli. Tra l'installazione di ambienti Python, la gestione dei file dei modelli e il ricomporre video e audio, quello che dovrebbe essere un semplice compito di miglioramento si trasforma spesso in un progetto da fine settimana.

Per semplificare l'intero processo, Aiarty Video Enhancer offre una soluzione pulita e all-in-one per l'upscaling e il restauro video, senza bisogno di scrivere codice, usare la riga di comando o fare congetture tecniche.

Con Aiarty, potete aumentare la risoluzione di video a bassa definizione portandoli a 1080p, 2K o persino 4K in pochi clic. Va anche oltre il semplice miglioramento della risoluzione: rimuove gli artefatti di compressione, riduce il rumore, migliora la nitidezza dei volti e ripristina i dettagli più fini in qualsiasi tipo di filmato, dalle vecchie cassette DV ai video girati con lo smartphone. Per i video a scatti, l'interpolazione dei fotogrammi aiuta a creare un aspetto più fluido.

Confronto delle Funzionalità: Aiarty Video Enhancer vs. Enhancer Video Open-Source

Sebbene Anime4K sia un noto progetto open-source, si concentra sul miglioramento della riproduzione in tempo reale piuttosto che sulla pre-elaborazione e l'esportazione di video, rendendolo fondamentalmente diverso dagli altri strumenti discussi. Per questo motivo, lo abbiamo escluso dalla tabella di confronto sottostante, che si concentra sugli strumenti progettati per l'upscaling e il miglioramento video basati su IA tramite pre-elaborazione.

Ecco come Aiarty Video Enhancer si confronta con le opzioni open-source più comuni:

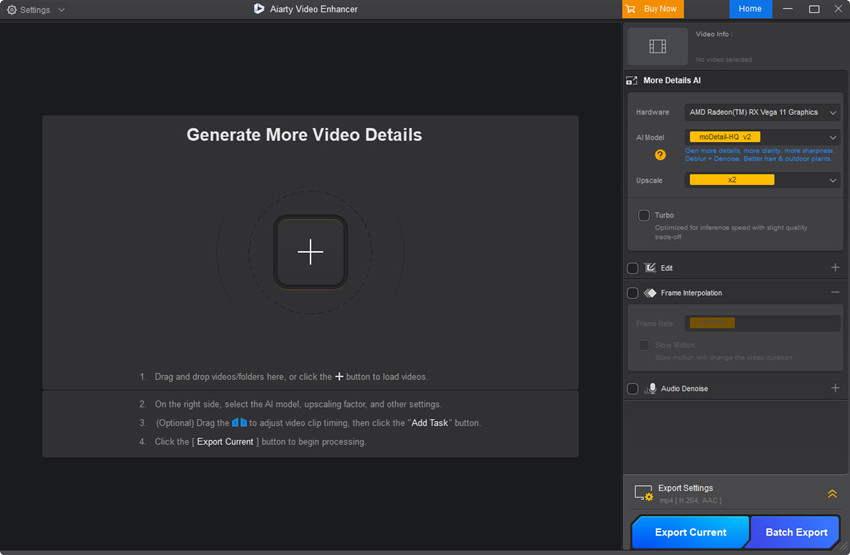

Come Usare Aiarty Video Enhancer per Aumentare la Risoluzione

Iniziare con Aiarty Video Enhancer è semplice e non richiede alcuna conoscenza pregressa di video editing. Basta seguire questi semplici passaggi per migliorare i vostri video senza intoppi:

Passo 1: Scaricate e installate Aiarty Video Enhancer sul vostro PC o Mac dal sito ufficiale.

Passo 2: Aprite il programma e trascinate il vostro file video nell'area di lavoro principale.

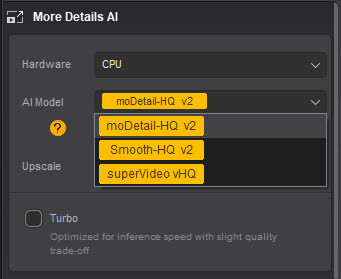

Passo 3: Dal menu a tendina "AI Model", selezionate il modello di miglioramento che meglio si adatta al vostro tipo di video.

code Code

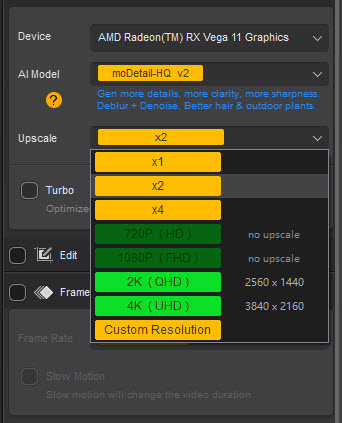

Passo 4: Scegliete la risoluzione di output desiderata nel menu "Upscale".

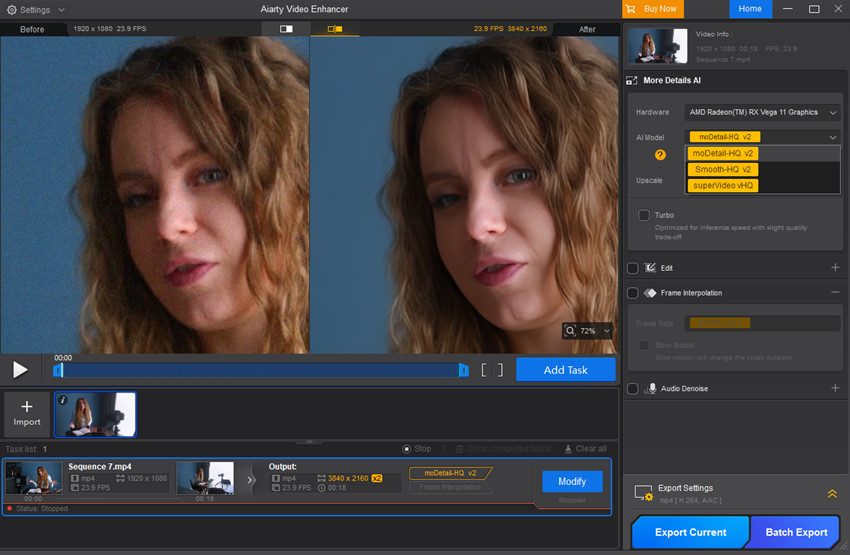

Passo 5: Fate clic sul pulsante "Preview" per vedere un rapido campione di come apparirà il video migliorato.

Durante la nostra prova, abbiamo scelto un upscaling 2x, passando da 1920x1080 a 3840x2160. Come potete vedere nello screenshot qui sotto, l'anteprima del video appare eccellente: tutto il rumore dell'originale è stato completamente rimosso.

Passo 6: Se l'anteprima soddisfa le vostre aspettative, aggiungete l'attività alla coda e selezionate "Export Current" per un singolo video o "Batch Export" per elaborare più video contemporaneamente.

Ecco altri due esempi che evidenziano le capacità di Aiarty Video Enhancer nell'upscaling e nel miglioramento dei video.

Esempio 1: La fonte è una vecchia clip registrata con una grana pesante e rumore cromatico. Dopo il miglioramento, il filmato mostra una nitidezza notevolmente superiore.

Esempio 2: Un video anime di 1190x724 è stato portato con successo a 2380x1448, con linee più nitide e artefatti ridotti.

Se volete guardare un video tutorial passo-passo con altri esempi di test, questa guida su YouTube fa al caso vostro.

Conclusione

Gli upscaler e enhancer video AI open-source offrono possibilità entusiasmanti per migliorare la qualità dei video senza spendere un centesimo. Tuttavia, come abbiamo visto, spesso comportano ostacoli tecnici, configurazioni complesse e funzionalità poco intuitive che possono rallentare o frustrare molti utenti.

Per coloro che cercano un modo più snello e senza complicazioni per aumentare la risoluzione e migliorare i video, strumenti come Aiarty Video Enhancer forniscono una soluzione potente ma accessibile. Con la sua interfaccia facile da usare, le funzionalità complete e le prestazioni affidabili, colma il divario tra la tecnologia AI avanzata e l'uso pratico quotidiano.

Che stiate restaurando vecchi video di famiglia, ripulendo filmati girati con lo smartphone o semplicemente desiderando contenuti più nitidi e chiari per i social media, scegliere lo strumento giusto fa tutta la differenza. Speriamo che questa guida vi aiuti a fare una scelta informata e a ottenere il massimo dal miglioramento video basato sull'intelligenza artificiale.