Die 5 besten kostenlosen Open-Source KI Video-Upscaler/Enhancer für Windows/Mac/Linux

Nicht jeder hat das Budget für hochwertige KI-Video-Enhancer. Wenn Sie schon einmal auf Reddit, GitHub oder in Video-Bearbeitungsforen gestöbert haben, sind Sie wahrscheinlich auf Leute gestoßen, die die gleiche Frage stellen: "Gibt es gute Open-Source-KI-Tools, die Videos hochskalieren oder verbessern können?"

Während die kommerziellen Optionen oft ausgefeilt und leistungsstark sind, hat auch eine Handvoll Open-Source-Projekte Aufmerksamkeit erregt, weil sie KI-basierte Funktionen wie Hochskalierung (Upscaling), Entunschärfung (Deblurring) und Entrauschung (Denoising) anbieten – und das alles ohne Preisschild. Einige sind speziell für Anime-Inhalte konzipiert, während andere auf die allgemeine Videoverbesserung abzielen. Aber wie effektiv sind sie in der Praxis? Und welche Kompromisse sind mit ihrer Verwendung verbunden?

Dieser Artikel führt Sie durch einige der beliebtesten kostenlosen Open-Source KI-Video-Upscaler und Enhancer, die heute verfügbar sind, einschließlich ihrer Stärken, ihrer Schwächen und dessen, was Sie bei der Einrichtung und Nutzung erwarten können.

Beliebte kostenlose Open-Source KI Video-Upscaler/Enhancer

Es gibt keinen Mangel an Open-Source-Tools, die behaupten, Videos mithilfe von KI hochskalieren oder verbessern zu können. Einige werden von Forschern erstellt und von GitHub-Mitwirkenden gepflegt, während andere von Solo-Entwicklern für den praktischen täglichen Gebrauch optimiert werden.

Nachfolgend finden Sie einige der beliebtesten kostenlosen Open-Source-Video-Upscaler und Enhancer, an die sich die Leute oft wenden. Jeder hat seine eigenen Stärken, Einschränkungen und Eigenheiten, die Sie kennen sollten, bevor Sie sich damit befassen.

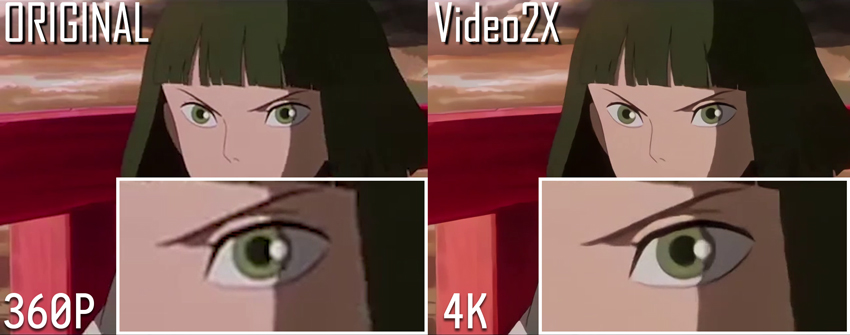

Video2X

Unterstützte Plattformen: Windows (voll unterstützt), Linux (eingeschränkte Unterstützung)

Video2X ist ein beliebtes Open-Source-Tool, das Videos hochskaliert, indem es einzelne Frames extrahiert, diese mit KI-gestützten Bild-Upscalern vergrößert und dann unter Verwendung dieser verarbeiteten Frames ein hochauflösendes Video rekonstruiert.

Der Prozess umfasst mehrere Schritte:

- Frame-Extraktion: Video2X verwendet zunächst FFmpeg, um das Video in einzelne Frames und eine Audiodatei aufzuteilen.

- Frame-Hochskalierung: Jeder Frame wird dann mit einem der unterstützten KI-Modelle wie waifu2x, SRMD oder Anime4KCPP hochskaliert. Die Upscaling-Modelle sind anpassbar, sodass Benutzer das Modell wählen können, das am besten zum jeweiligen Inhaltstyp passt (z. B. Anime vs. reales Filmmaterial).

- Video-Rekonstruktion: Nachdem die Frames verarbeitet wurden, setzt FFmpeg die hochskalierten Frames und das Original-Audio wieder zu einem hochauflösenden Endvideo zusammen.

Der Prozess kann langsam sein, insbesondere bei der Verarbeitung langer Videos oder wenn keine GPU-Beschleunigung verfügbar ist.

Für fortgeschrittene Benutzer, die mit Skripting vertraut sind, ist es möglich, manuell ein einfaches Batch- oder Bash-Skript zu schreiben, um diesen Prozess, einschließlich der Aufteilung und Zusammenführung des Videos, für noch mehr Anpassungsmöglichkeiten zu automatisieren.

Eine einfache grafische Benutzeroberfläche (GUI) ist für Windows-Benutzer verfügbar, während Linux-Benutzer auf die Kommandozeilen-Bedienung angewiesen sind.

- Unterstützt mehrere KI-Backends für verschiedene Inhaltstypen

- Bietet eine Windows-GUI, die die Nutzung für nicht-technische Benutzer vereinfacht

- Stapelverarbeitung (Batch-Processing) für lange Videos oder ganze Ordner wird unterstützt

- Kostenlos und Open-Source ohne Funktionseinschränkungen oder Wasserzeichen

- Die Verarbeitung ist ohne GPU-Beschleunigung langsam; eine NVIDIA-GPU wird dringend empfohlen

- Audio wird nicht zusammen mit dem Video verarbeitet und muss separat wieder angehängt werden

- Installation und Modellkonfiguration können für Anfänger verwirrend sein

- Die Linux-Unterstützung ist eingeschränkt und erfordert manuelle Einrichtung

- Dieses Tool läuft nicht nativ auf macOS

Installation & Verwendung:

1. Erstellen Sie das Video2X-Projekt auf Ihrem Computer

- Prüfen Sie, wie Sie Video2X unter Windows erstellen: https://docs.video2x.org/building/windows.html

- Prüfen Sie, wie Sie die Qt6-GUI von Video2X unter Windows erstellen: https://docs.video2x.org/building/windows-qt6.html

- Prüfen Sie, wie Sie Video2X unter Linux erstellen: https://docs.video2x.org/building/linux.html

2. Laden Sie Video2X herunter und installieren Sie es

Damit Video2X reibungslos läuft, muss Ihr System die folgenden Mindestanforderungen an die Hardware erfüllen.

CPU

- Die vorkompilierten Binärdateien erfordern CPUs mit AVX2-Unterstützung.

- Intel: Haswell (Q2 2013) oder neuer

- AMD: Excavator (Q2 2015) oder neuer

GPU

- Die GPU muss Vulkan unterstützen.

- NVIDIA: Kepler (GTX 600er Serie, Q2 2012) oder neuer

- AMD: GCN 1.0 (Radeon HD 7000er Serie, Q1 2012) oder neuer

- Intel: HD Graphics 4000 (Q2 2012) oder neuer

Tipp: Wenn Ihr Computer keine leistungsstarke GPU hat, können Sie Video2X trotzdem kostenlos auf Google Colab verwenden. Google bietet Zugang zu Hochleistungs-GPUs wie der NVIDIA T4, L4 oder A100, die Sie für bis zu 12 Stunden pro Sitzung nutzen können.

Installation unter Windows (Kommandozeilen-Version)

Sie können die neueste vorkompilierte Version von GitHub herunterladen. So installieren Sie es in Ihrem lokalen Benutzerverzeichnis:

Nach dem Entpacken fügen Sie *%LOCALAPPDATA%\Programs\video2x* zu den Umgebungsvariablen Ihres Systems hinzu, um einen einfachen Zugriff zu ermöglichen.

Installation der Windows Qt6 GUI

Wenn Sie eine grafische Benutzeroberfläche bevorzugen, bietet die Qt6-Version von Video2X eine übersichtlichere Erfahrung. Laden Sie die Installationsdatei – video2x-qt6-windows-amd64-installer.exe – von der Releases-Seite herunter und doppelklicken Sie darauf, um sie zu starten.

Der Einrichtungsassistent führt Sie durch den Installationsprozess. Sie können den Installationspfad auswählen und entscheiden, ob Sie eine Desktop-Verknüpfung erstellen möchten.

Installation unter Linux

Linux-Benutzer sollten den Anweisungen in der offiziellen Linux-Installationsanleitung folgen.

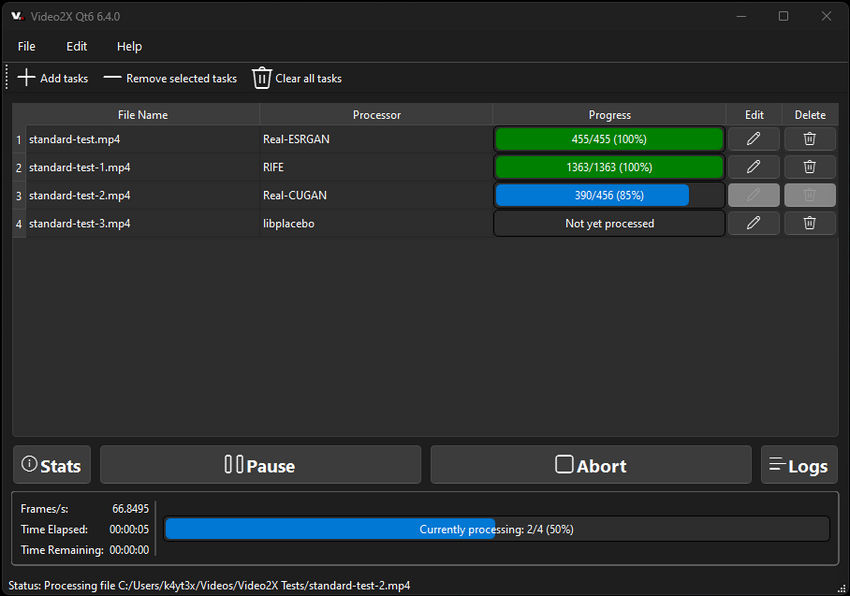

3. Führen Sie Video2X aus

Sie können Video2X entweder über die Kommandozeile oder über die GUI (unter Windows) ausführen.

Zur Verwendung der Kommandozeile beachten Sie bitte die CLI-Dokumentation. Sie können Ein- und Ausgabepfade, KI-Modelle wie realesrgan, Ausgabeoptionen und mehr definieren.

Beispielbefehl:

Um die GUI zu verwenden, starten Sie einfach Video2X Qt6. Laden Sie Ihr Video, konfigurieren Sie Einstellungen wie GPU-Backend, Verarbeitungsmodus und Filter und klicken Sie dann auf die Schaltfläche Run, um die Hochskalierung zu starten.

Real-ESRGAN

Unterstützte Plattformen: Windows, Linux, macOS

Real-ESRGAN ist ein weit verbreiteter, kostenloser Open-Source KI-Bild- und Video-Upscaler, der von dem Team hinter ESRGAN entwickelt wurde. Basierend auf dem PyTorch-Framework bietet es eine qualitativ hochwertige Bild- und Videohosksskalierung unter Verwendung vorab trainierter Generative Adversarial Networks (GANs). Obwohl es ursprünglich für die Super-Resolution einzelner Bilder konzipiert wurde, kann Real-ESRGAN auch auf Videos angewendet werden, indem es Frame für Frame verarbeitet wird. Dies macht es zu einer starken Wahl für die Wiederherstellung von niedrig aufgelöstem oder komprimiertem Videoinhalt.

Es funktioniert besonders gut bei realen Szenen – wie Landschaften, Gesichtern oder minderwertigem Smartphone-Filmmaterial – und ist bekannt für seine Fähigkeit, feine Details wiederherzustellen und gleichzeitig Rauschen und Komprimierungsartefakte zu reduzieren.

- Modernste Bildverbesserungsqualität, insbesondere für Fotos und Videos aus der realen Welt

- Mehrere vorab trainierte Modelle verfügbar (allgemein, Anime, Gesichtsrestaurierung usw.)

- Aktiv gepflegt und unterstützt durch ein starkes Forschungsteam

- Kann geskriptet oder in benutzerdefinierte Video-Workflows integriert werden

- Keine integrierte GUI; erfordert die Verwendung der Kommandozeile oder manuelles Skripting

- Erfordert Frame-Extraktion und Rekombination für die Videonutzung (nicht automatisiert)

- Erfordert eine Python-Umgebung und grundlegende Vertrautheit mit PyTorch

- Die Verarbeitung kann auf der CPU langsam sein; für den praktischen Gebrauch wird eine GPU dringend empfohlen

Installation & Verwendung:

1. Python und Abhängigkeiten installieren

- Stellen Sie sicher, dass Python 3.7 oder neuer installiert ist

- Das Repository klonen:

- Erforderliche Pakete installieren

cd Real-ESRGAN

# Wir verwenden BasicSR sowohl für Training als auch für Inference

pip install basicsr

# facexlib und gfpgan sind für die Gesichtsverbesserung

pip install facexlib

pip install gfpgan

pip install -r requirements.txt

python setup.py develop

2. Vorab trainierte Modelle herunterladen

Das Projekt unterstützt verschiedene Modelle:

- RealESRGAN_x4plus (allgemeine Verwendung)

- RealESRGAN_x4plus_anime_6B (Anime-Bilder)

- realesr-general-x4v3 (für komprimierte Bilder)

Laden Sie die gewünschten .pth-Modelldateien vom GitHub Release oder den bereitgestellten Links herunter.

3. Video vorbereiten (Frame-Extraktion)

Verwenden Sie FFmpeg, um Frames aus Ihrem Eingabevideo zu extrahieren:

4. Real-ESRGAN auf extrahierten Frames ausführen

Beispielbefehl (für 4x Hochskalierung):

5. Frames wieder zu einem Video zusammensetzen

Verwenden Sie erneut FFmpeg:

6. (Optional) Audio aus dem Originalvideo wieder hinzufügen

Real-ESRGAN eignet sich am besten für Benutzer, die mit Python und Kommandozeilen-Tools vertraut sind, oder für diejenigen, die hochwertige Hochskalierung in automatisierte Pipelines integrieren möchten. Obwohl die Einrichtung technischer ist als bei GUI-basierten Optionen, sprechen die visuellen Ergebnisse oft für sich – insbesondere bei der Wiederherstellung von Details in verschwommenem oder niedrig aufgelöstem Filmmaterial.

Tipp: Genau wie Video2X kann Real-ESRGAN auch auf Google Colab ausgeführt werden. Sehen Sie sich dieses Video an, um zu erfahren, wie Sie Colab verwenden, um Videos auf HD oder sogar 4K hochzuskalieren, ohne eine leistungsstarke lokale GPU zu benötigen.

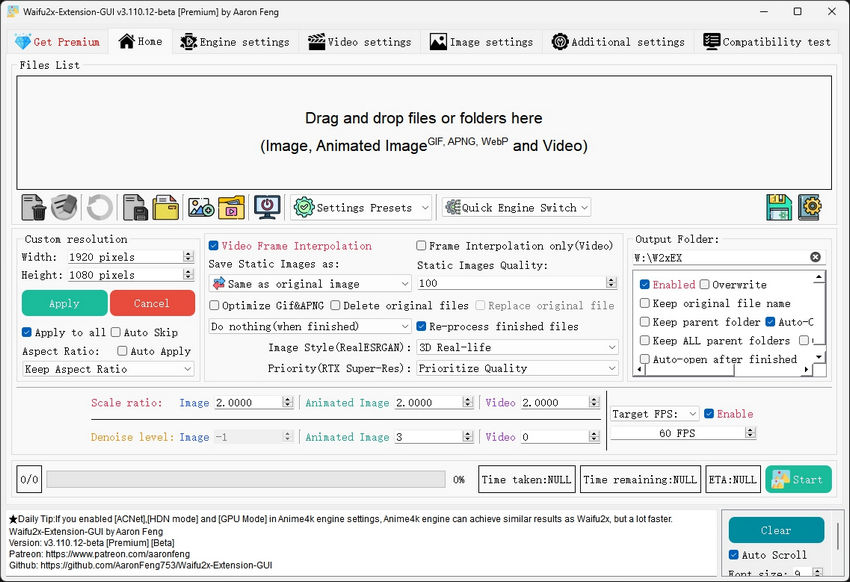

Waifu2x Extension GUI

Unterstützte Plattform: Windows

Waifu2x Extension GUI ist eine benutzerfreundliche, nur für Windows verfügbare Desktop-Anwendung, die mehrere KI-Upscaler – darunter waifu2x, Real-ESRGAN und Anime4K – in einer einzigen grafischen Benutzeroberfläche bündelt. Ursprünglich für Bilder und Videos im Anime-Stil konzipiert, wurde es inzwischen erweitert, um reale Inhalte mit zusätzlichen Modelloptionen zu unterstützen. Es wird weithin geschätzt, weil es einfach zu installieren und zu bedienen ist und keine Kommandozeilenoperationen erfordert.

Im Gegensatz zu vielen Open-Source-Tools ist die Waifu2x Extension GUI auf Komfort ausgelegt: Sie übernimmt die Frame-Extraktion, Hochskalierung, Videorekonstruktion und sogar die Audio-Synchronisierung – alles innerhalb derselben Oberfläche. Dies macht es zu einer der anfängerfreundlichsten Optionen, die für die KI-basierte Videoverbesserung unter Windows verfügbar sind.

- All-in-One-GUI, die Hochskalierung von Bildern, GIFs und Videos unterstützt

- Enthält mehrere KI-Backends (waifu2x-ncnn-vulkan, Real-ESRGAN, Anime4K, SRMD)

- Integrierte Unterstützung für Video-/Audio-Muxing – keine FFmpeg-Kommandozeile erforderlich

- Bietet Stapelverarbeitung (Batch Processing) und erweiterte Einstellungen für erfahrene Benutzer

- Kein Python oder externe Abhängigkeiten erforderlich

- Nur Windows – keine Unterstützung für macOS oder Linux

- Die Verarbeitung kann auf leistungsschwachen GPUs zeitaufwändig sein

- Modelloptionen und Update-Häufigkeit hängen von der Pflege durch den Entwickler ab

- Etwas größerer Installer (~1,5 GB aufgrund gebündelter Modelle und Abhängigkeiten)

Installation & Verwendung:

1. Installer herunterladen

Gehen Sie zur GitHub- oder Gitee-Release-Seite des Projekts: https://github.com/AaronFeng753/Waifu2x-Extension-GUI. Wählen Sie die neueste .exe-Version (z. B. Waifu2x-Extension-GUI-v...-Installer.exe).

2. Programm installieren und starten

Führen Sie den Installer aus. Öffnen Sie nach Abschluss die Anwendung über die Desktop-Verknüpfung oder das Startmenü.

3. Ihr Video laden

Ziehen Sie Ihre Videodatei per Drag & Drop in das Programm, oder klicken Sie auf "Add Files" und wählen Sie Ihre Eingabe aus.

4. Hochskalierungseinstellungen auswählen

- KI-Modell auswählen (z. B. Real-ESRGAN, waifu2x-ncnn-vulkan oder Anime4KCPP)

- Ausgabeauflösungs-Multiplikator festlegen (z. B. 2× oder 4×)

- Optional: Entrauschen, Frame-Interpolation oder Artefakt-Reduktion anwenden

5. Verarbeitung starten

Klicken Sie auf die Schaltfläche "Start". Die App übernimmt alles automatisch: extrahiert Frames, skaliert hoch, baut das Video neu auf und synchronisiert das Audio.

6. Auf die Ausgabe zugreifen

Das hochskalierte Video wird im angegebenen Ausgabeordner gespeichert und kann sofort verwendet oder hochgeladen werden.

Die Waifu2x Extension GUI ist ideal für Benutzer, die solide KI-Hochskalierungsergebnisse erzielen möchten, ohne Code anfassen oder komplexe Umgebungen einrichten zu müssen. Obwohl es weniger anpassbar ist als skriptbasierte Tools, bietet es eine ausgefeilte Out-of-the-Box-Erfahrung, die kaum zu übertreffen ist – insbesondere für Anime und niedrig aufgelöste Webvideos.

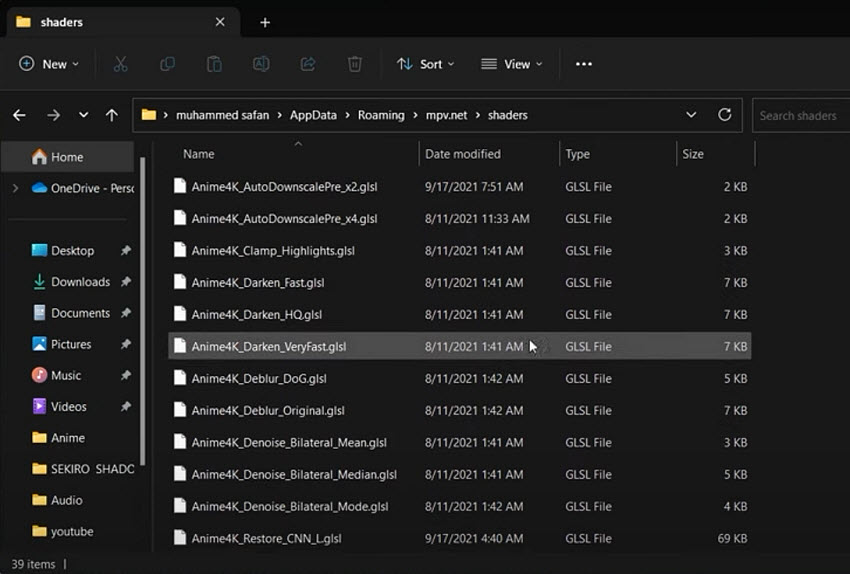

Anime4K

Unterstützte Plattformen: Windows, macOS, Linux (über Video-Player oder benutzerdefinierte Skripte)

Anime4K ist ein leichtgewichtiger, Open-Source Video-Upscaling-Algorithmus, der speziell für Anime und Strichgrafik-Inhalte entwickelt wurde. Im Gegensatz zu anderen Tools, die auf Deep Learning oder GAN-Modellen basieren, verwendet Anime4K effiziente OpenCL- oder Vulkan-Shader, die direkt auf Ihrer GPU ausgeführt werden. Das macht es schnell, Echtzeit-fähig und sogar für Low-End-Hardware geeignet.

Anstatt Video-Frames zu extrahieren und wieder zusammenzusetzen, wird Anime4K typischerweise innerhalb von Video-Playern wie MPV oder VLC über Shader-Skripte verwendet. Es kann auch offline mithilfe von FFmpeg-Filtern oder Kommandozeilen-Tools angewendet werden, aber seine größte Stärke liegt in der Echtzeit-Wiedergabeverbesserung – wodurch alte Anime oder niedrig aufgelöste Webvideos sofort sauberer und schärfer aussehen.

- Echtzeit-Verbesserung mit fast keiner Verzögerung

- Extrem leichtgewichtig – funktioniert auf integrierten GPUs

- Großartig für Anime, Cartoons und Inhalte im Strichgrafik-Stil

- Funktioniert innerhalb von MPV, VLC oder mit benutzerdefinierten Skripten – keine separate Frame-Extraktion erforderlich

- Plattformübergreifende Unterstützung

- Nicht geeignet für fotografische oder reale Videoinhalte

- Keine grafische Benutzeroberfläche oder verpackter Installer

- Erfordert manuelle Konfiguration zur Integration in Video-Player

- Die Ausgabequalität ist nicht so scharf oder detailliert wie bei Deep-Learning-basierten Upscalern

Installation & Verwendung:

Option 1: Echtzeit-Wiedergabe mit MPV

- Laden Sie den MPV-Player herunter unter: https://mpv.io/

- Klonen oder laden Sie das Anime4K-Repository herunter: https://github.com/bloc97/Anime4K

- Legen Sie die Shader-Dateien (z. B. Anime4K_Clamp_Hybrid.glsl) in den Shader-Ordner von MPV.

- Bearbeiten Sie mpv.conf, um den Shader zu aktivieren: glsl-shaders="~~/shaders/Anime4K_Clamp_Hybrid.glsl"

- Öffnen Sie Ihr Video mit MPV, und die Verbesserung wird in Echtzeit angewendet.

Option 2: Offline-Verarbeitung mit FFmpeg (Erfahrene Benutzer)

Einige Forks (wie Anime4KCPP) bieten Möglichkeiten, Anime4K-Filter direkt auf Videodateien auszuführen, aber dies erfordert das Kompilieren des Tools oder die Verwendung spezifischer FFmpeg-Builds mit Shader-Unterstützung – nicht anfängerfreundlich.

Anime4K eignet sich am besten für Anime-Fans oder alle, die eine sofortige visuelle Verbesserung für niedrig aufgelöste animierte Inhalte wünschen. Es bietet nicht die tiefgreifenden Wiederherstellungsfunktionen von KI-Modellen wie Real-ESRGAN oder Video2X, aber seine Geschwindigkeit und Einfachheit machen es zu einer ausgezeichneten Wahl für die Wiedergabe oder leichte Verbesserung.

Wie Sie sehen können, gibt es Open-Source-Video-Enhancer in vielen Formen – von benutzerfreundlichen GUIs wie der Waifu2x Extension GUI bis hin zu leichtgewichtigen Shader-basierten Lösungen wie Anime4K.

Obwohl diese Tools leistungsstark sind und nichts kosten, sind sie auch mit bestimmten Kompromissen verbunden, die für Anfänger oder sogar erfahrene Benutzer frustrierend sein können.

Im nächsten Abschnitt werfen wir einen Blick auf einige der häufigsten Herausforderungen, denen sich Menschen bei der Arbeit mit diesen Open-Source-Lösungen stellen müssen.

REAL Video Enhancer

Unterstützte Plattformen: Windows, Linux, macOS

REAL Video Enhancer ist eine All-in-One-Desktop-Anwendung, die für die KI-gestützte Videoverbesserung, einschließlich Frame-Interpolation und Hochskalierung, entwickelt wurde. Es wurde als moderne, plattformübergreifende Alternative zu älterer Software wie Flowframes erstellt und bietet eine benutzerfreundliche Erfahrung ohne die Notwendigkeit von Kommandozeilenwissen.

Die Anwendung nutzt modernste KI-Modelle wie RIFE für die Video-Interpolation und Real-ESRGAN für die Hochskalierung. Sie verwendet hochoptimierte Inferenz-Engines wie TensorRT und NCNN, um die Leistung zu maximieren, insbesondere auf modernen GPUs. Im Gegensatz zu vielen GUI-Tools unterstützt der REAL Video Enhancer alle wichtigen Desktop-Betriebssysteme, was ihn zu einer vielseitigen Wahl für eine breite Palette von Benutzern macht.

- Plattformübergreifende Unterstützung, verfügbar für Windows, Linux und macOS.

- Hochgradig optimiert, nutzt TensorRT- und NCNN-Backends für überragende Leistung auf unterstützter Hardware.

- Umfassende Funktionen, integriert Frame-Interpolation (RIFE), Hochskalierung (Real-ESRGAN) und Videodekomprimierung in einer einzigen Oberfläche.

- Benutzerfreundliche GUI, bietet eine einfache und intuitive Oberfläche für einen unkomplizierten Workflow.

- Enthält erweiterte Funktionen wie Discord RPC-Integration, Szenenwechselerkennung und eine Echtzeit-Vorschau des gerenderten Frames.

- Ressourcenintensiv, erfordert eine leistungsstarke GPU mit mindestens 8 GB VRAM und 16 GB RAM für optimale Leistung.

- Größere Download-Größe, wobei die TensorRT-Version aufgrund gebündelter Modelle und Abhängigkeiten potenziell bis zu 16 GB erreichen kann.

- Spezifische Hardware-Anforderungen, da die optimale Leistung an bestimmte GPUs und Betriebssysteme gebunden ist, die das TensorRT-Backend vollständig unterstützen.

Installation & Verwendung

1. Anwendung herunterladen

Gehen Sie zur offiziellen Projektseite auf GitHub: https://github.com/TNTwise/REAL-Video-Enhancer/releases/tag/RVE-2.3.6.

Laden Sie die entsprechende Version für Ihr Betriebssystem herunter (Windows .exe, Linux .flatpak oder macOS .dmg).

2. Installieren und starten

Führen Sie das heruntergeladene Installationsprogramm aus. Folgen Sie den Anweisungen, um die Installation abzuschließen. Starten Sie die Anwendung anschließend über Ihren Desktop oder den Anwendungsordner.

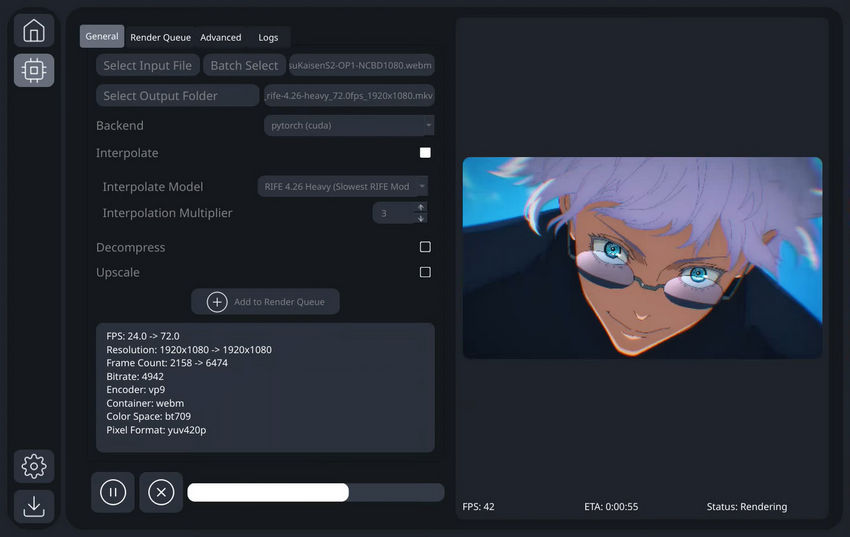

3. Ihre Videodatei laden

Klicken Sie im Reiter "General" auf "Select Input File" oder "Batch Select", um das/die Video(s) zu importieren, das/die Sie verarbeiten möchten.

4. Verarbeitungseinstellungen konfigurieren

- Backend: Wählen Sie ein geeignetes Backend, z. B. pytorch (cuda), um die Leistung Ihrer GPU zu nutzen.

- Interpolate: Aktivieren Sie dieses Kästchen, um die Frame-Interpolation zu ermöglichen.

- Interpolate Model: Wählen Sie ein Modell für die Frame-Interpolation, wie RIFE 4.26 Heavy.

- Interpolation Multiplier: Stellen Sie den Interpolationsfaktor ein, z. B. 3, wodurch die Bildrate des Videos um das Dreifache erhöht wird.

- Decompress: Aktivieren Sie dieses Kästchen, um das Video zu dekomprimieren.

- Upscale: Aktivieren Sie dieses Kästchen, um die Hochskalierung zu ermöglichen, und wählen Sie das entsprechende Modell aus.

5. Zur Render-Warteschlange hinzufügen

Sobald Sie alle Ihre Einstellungen konfiguriert haben, klicken Sie auf "Add to Render Queue". Anschließend können Sie Ihre ausstehenden Aufgaben im Reiter "Render Queue" verwalten.

6. Verarbeitung starten

Klicken Sie unten auf die Wiedergabetaste (►), um die Verarbeitungsaufgabe zu starten.

Die intuitive GUI des REAL Video Enhancers vereinfacht komplexe Videoverbesserungsvorgänge und ermöglicht es selbst Anfängern, problemlos damit zu beginnen.

Häufige Schwierigkeiten bei der Verwendung von Open Source KI Video-Enhancern

Obwohl Open-Source KI Video-Upscaler beeindruckende Funktionen bieten, sind sie oft mit einer steilen Lernkurve verbunden. Viele Benutzer laden diese Tools herunter und erwarten eine Plug-and-Play-Erfahrung, nur um festzustellen, dass das Funktionieren technische Schritte, die Verwaltung von Abhängigkeiten oder stundenlanges Ausprobieren erfordert. Hier sind einige der häufigsten Herausforderungen, denen Benutzer begegnen.

1. Komplexe Installation und Einrichtung

Viele Open-Source KI Video-Enhancer basieren auf Python, PyTorch oder anderen Frameworks, die eine manuelle Installation erfordern. Möglicherweise müssen Sie GitHub-Repositories klonen, Abhängigkeiten installieren, Umgebungsvariablen konfigurieren oder separate KI-Modelle herunterladen – all das, bevor Sie überhaupt ein einziges Video verarbeiten können. Wenn Sie mit diesen Tools nicht bereits vertraut sind, kann sich der Prozess überwältigend anfühlen.

2. Fehlende einheitliche Benutzeroberfläche

Im Gegensatz zu kommerziellen Tools, die in der Regel ausgefeilte Oberflächen und optimierte Arbeitsabläufe bieten, konzentrieren sich die meisten Open-Source-Projekte auf die Backend-KI-Funktionalität. Sie müssen oft Video-Frames mit FFmpeg extrahieren, sie separat hochskalieren und das Video dann manuell wieder zusammensetzen. GUI-Optionen existieren zwar, sind aber oft auf Windows beschränkt oder möglicherweise veraltet.

3. Audio-Handhabung wird oft ignoriert

Viele Tools konzentrieren sich ausschließlich auf den visuellen Teil des Videos und lassen das Audio außen vor. Infolgedessen müssen Benutzer Audio-Spuren manuell extrahieren und wieder anhängen, indem sie FFmpeg oder andere Tools verwenden. Dies fügt einem ohnehin schon komplexen Workflow einen weiteren Schritt hinzu und erhöht die Wahrscheinlichkeit von Fehlern wie der Desynchronisation.

4. Begrenzte Unterstützung und Dokumentation

Da es sich bei diesen Tools oft um Leidenschaftsprojekte oder Forschungsdemos handelt, fehlt es ihnen in der Regel an formalen Support-Kanälen. Die Dokumentation kann inkonsistent, veraltet oder für Anfänger zu technisch sein. Wenn Sie nicht weiterkommen, besteht Ihr einziger Ausweg möglicherweise darin, GitHub-Issues, Reddit-Threads oder Online-Foren zu durchsuchen – was nicht immer zu klaren Antworten führt.

Eine einfachere, effizientere Alternative zu Open Source Video-Upscalern/Enhancern

Wenn Sie schon einmal damit gekämpft haben, einen Open-Source KI-Upscaler zum Laufen zu bringen, sind Sie nicht allein. Zwischen der Installation von Python-Umgebungen, der Verwaltung von Modelldateien und dem erneuten Zusammenfügen von Video und Audio wird aus einer eigentlich einfachen Verbesserungsaufgabe oft ein Wochenendprojekt.

Um den gesamten Prozess zu vereinfachen, bietet der Aiarty Video Enhancer eine saubere, All-in-One-Lösung für Video-Hochskalierung und -Wiederherstellung – kein Coding, keine Kommandozeilen-Tools und kein technisches Rätselraten erforderlich.

Mit Aiarty können Sie Videos mit niedriger Auflösung mit nur wenigen Klicks auf 1080p, 2K oder sogar 4K hochskalieren. Es geht auch über die grundlegende Auflösungsverbesserung hinaus – es entfernt Komprimierungsartefakte, reduziert Rauschen, entschärft Gesichter und stellt feine Details in allem wieder her, von alten DV-Kassetten bis hin zu Aufnahmen mit dem Mobiltelefon. Für ruckelnde Videos sorgt die Frame-Interpolation für einen flüssigeres Aussehen.

Funktionsvergleich: Aiarty Video Enhancer vs. Open-Source Video-Enhancer

Obwohl Anime4K ein bekanntes Open-Source-Projekt ist, konzentriert es sich auf die Echtzeit-Wiedergabeverbesserung anstatt auf die Vorverarbeitung und den Export von Videos – was es grundlegend von den anderen besprochenen Tools unterscheidet. Aus diesem Grund haben wir es aus der folgenden Vergleichstabelle ausgeschlossen, die sich auf Tools konzentriert, die für die KI-basierte Video-Hochskalierung und -Verbesserung durch Vorverarbeitung entwickelt wurden.

Hier sehen Sie, wie sich der Aiarty Video Enhancer im Vergleich zu den am häufigsten verwendeten Open-Source-Optionen schlägt:

So verwenden Sie den Aiarty Video Enhancer, um Ihre Videos hochzuskalieren/zu verbessern

Der Einstieg in den Aiarty Video Enhancer ist unkompliziert und erfordert keine vorherigen Kenntnisse in der Videobearbeitung. Befolgen Sie einfach diese einfachen Schritte, um Ihre Videos reibungslos zu verbessern:

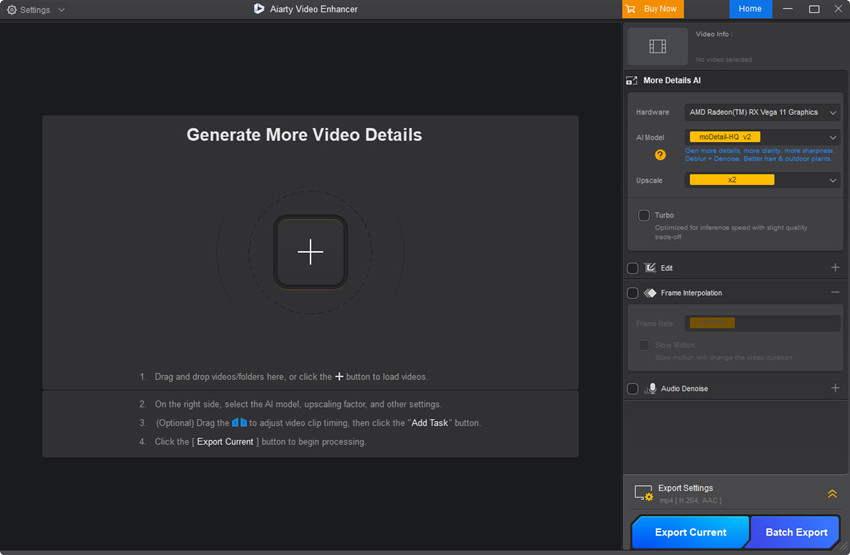

Schritt 1: Laden Sie den Aiarty Video Enhancer von der offiziellen Website herunter und installieren Sie ihn auf Ihrem PC oder Mac.

Schritt 2: Öffnen Sie das Programm und ziehen Sie Ihre Videodatei in den Hauptarbeitsbereich.

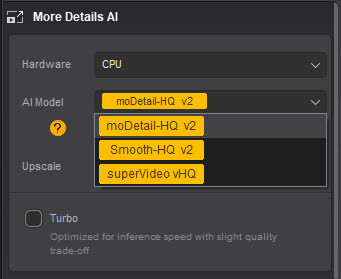

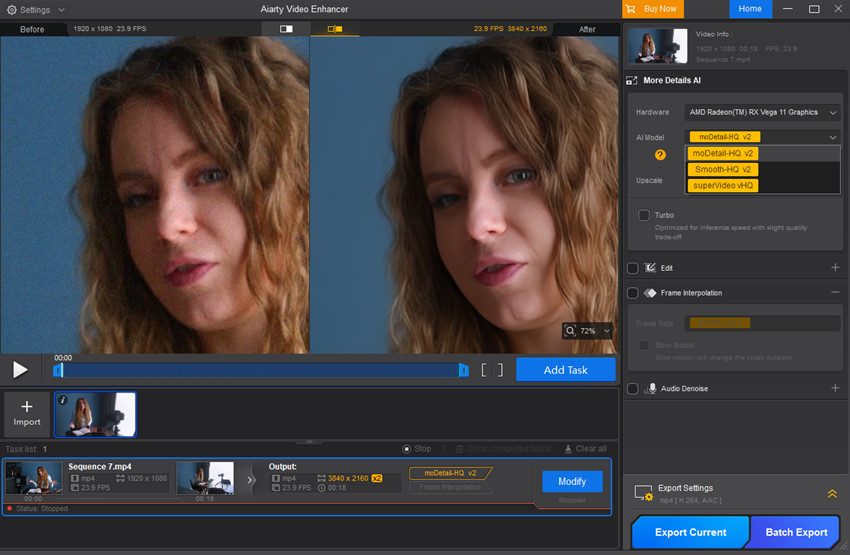

Schritt 3: Wählen Sie im Dropdown-Menü AI Model das Verbesserungsmodell aus, das am besten zu Ihrem Videotyp passt.

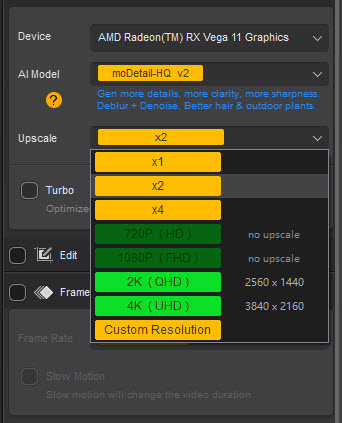

Schritt 4: Wählen Sie unter dem Menüpunkt Upscale Ihre gewünschte Ausgabeauflösung.

Schritt 5: Klicken Sie auf die Schaltfläche Preview, um eine kurze Vorschau zu sehen, wie das verbesserte Video aussehen wird.

In meinem Test wählte ich die 2-fache Hochskalierung, von 1920x1080 auf 3840x2160. Wie Sie im folgenden Screenshot sehen können, sieht die Videovorschau ausgezeichnet aus – das gesamte Rauschen des Originals wurde vollständig entfernt.

Schritt 6: Wenn die Vorschau Ihren Erwartungen entspricht, fügen Sie die Aufgabe der Warteschlange hinzu und wählen Sie entweder "Export Current" für ein einzelnes Video oder "Batch Export", um mehrere Videos gleichzeitig zu verarbeiten.

Hier sind zwei weitere Beispiele, die die Fähigkeiten des Aiarty Video Enhancers beim Hochskalieren und Verbessern von Videos hervorheben.

Beispiel 1: Die Quelle ist ein alter Aufnahme-Clip mit starkem Rauschen und Farbrauschen. Nach der Verbesserung zeigt das Filmmaterial eine spürbare Klarheit.

Beispiel 2: Ein 1190x724 Anime-Video wurde erfolgreich auf 2380x1448 hochskaliert, mit schärferen Linien und reduzierten Artefakten.

Wenn Sie ein Schritt-für-Schritt-Video-Tutorial mit weiteren Testbeispielen ansehen möchten, finden Sie hier die YouTube-Anleitung.

Fazit

Open-Source KI Video-Upscaler und Enhancer bieten aufregende Möglichkeiten, die Videoqualität zu verbessern, ohne einen Cent auszugeben. Wie wir jedoch gesehen haben, bringen sie oft technische Hürden, komplexe Setups und begrenzte benutzerfreundliche Funktionen mit sich, die viele Benutzer verlangsamen oder frustrieren können.

Für diejenigen, die einen **einfacheren und problemlosen Weg** suchen, Videos hochzuskalieren und zu verbessern, bieten Tools wie der **Aiarty Video Enhancer** eine leistungsstarke und dennoch zugängliche Lösung. Mit seiner benutzerfreundlichen Oberfläche, umfassenden Funktionen und zuverlässigen Leistung überbrückt es die Lücke zwischen fortschrittlicher KI-Technologie und dem praktischen täglichen Gebrauch.

Egal, ob Sie alte Familienvideos wiederherstellen, Smartphone-Aufnahmen bereinigen oder einfach nur schärfere, klarere Inhalte für soziale Medien wünschen, die Wahl des richtigen Tools macht den entscheidenden Unterschied. Wir hoffen, dass dieser Leitfaden Ihnen hilft, eine fundierte Entscheidung zu treffen und das Beste aus der KI-gestützten Videoverbesserung herauszuholen.